论文 1

《SANVis: Visual Analytics for Understanding Self-Attention Networks》

简介

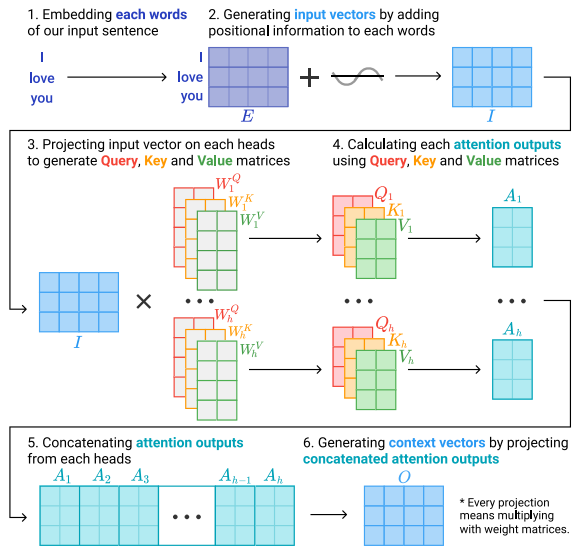

这一篇文章是关于 Self-Attention 可视化的,可视化的网络有 Transformer 和 BERT。里面有一幅 Transformer 的图很好,贴过来。

论文 2

《BERT Meets Chinese Word Segmentation》

简介

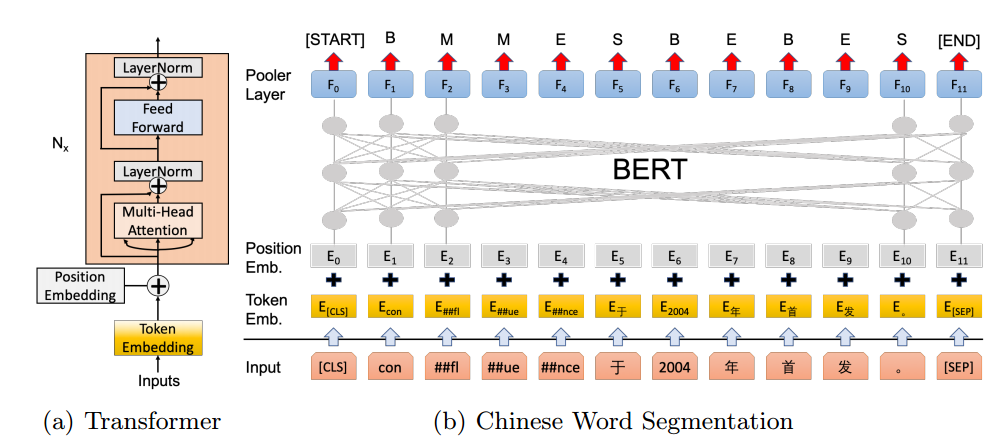

这篇论文介绍 BERT 用于中文分词任务的。里面提到一点有趣的地方在于,BERT 后面接 Softmax 和 CRF 层的最终效果差不多,但是 SoftMax 更快。

模型结构

实验结果

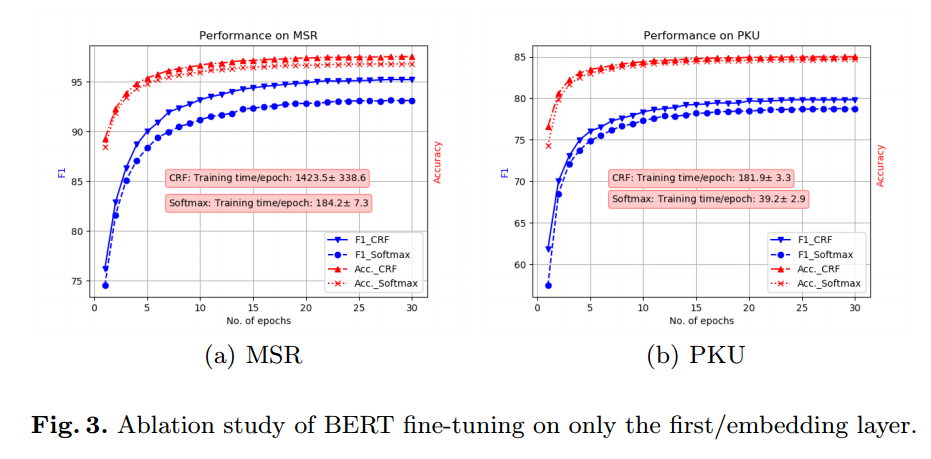

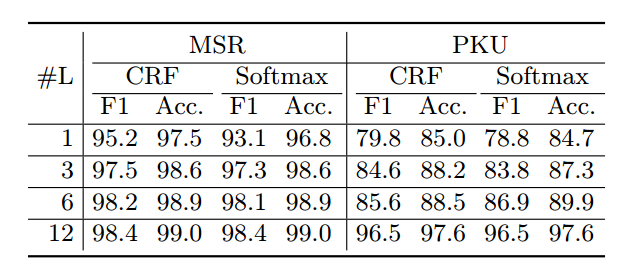

注意这个是只使用 BERT 的第一层做特征提取的效果,这里 CRF 要比 SoftMax 好。

这个是不同层做特征提取的效果,可以看到微调 12 层的时候 SoftMax 和 CRF 效果差不多。

论文结果

- BERT 可以稍微提高 CWS 任务的性能。就 Softmax 分类器来说,MSR 数据集和 PKU 数据集 F1 分数分别有 + 0.3 和 + 0.4 提高。

- 充分训练的时候,CRF 和 Softmax 达到相同的性能。但是由于 Softmax 预测时间更短,因此更受欢迎。

- 随着模型尺寸的增加,BERT 的性能逐渐提高。

论文 3

《Enriching BERT with Knowledge Graph Embeddings for Document Classification》

简介

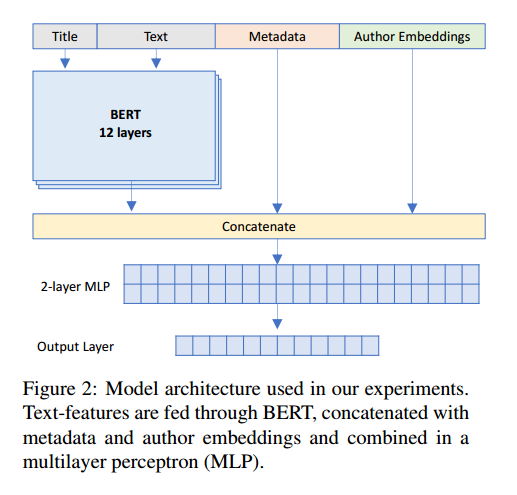

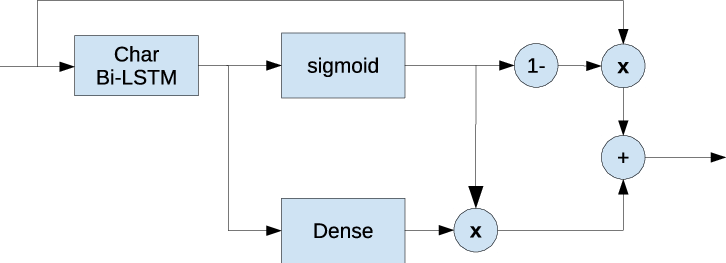

这篇文章是一个比赛的方法,这个比赛是进行文档分类,但是还有一些其他的数据(作者,ISBN 等等),因此要做特征的融合,作者提出的融合方法很简单,如下:

论文 4

《Subword ELMo》

简介

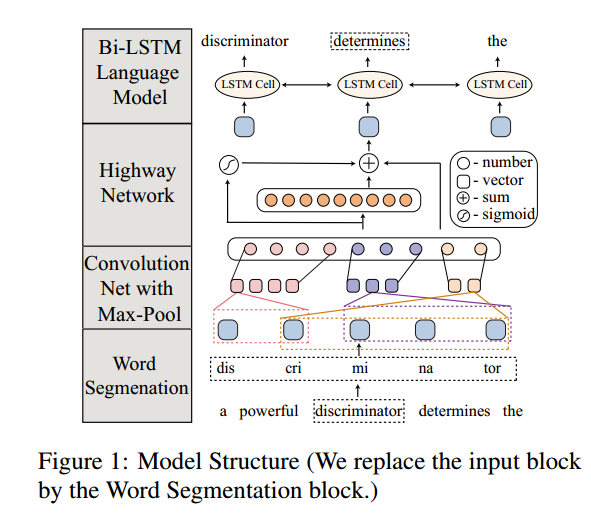

这篇文章主要使用 Subword 提升 ELMo 的性能,思路很简单。这里主要看一下网络结构。

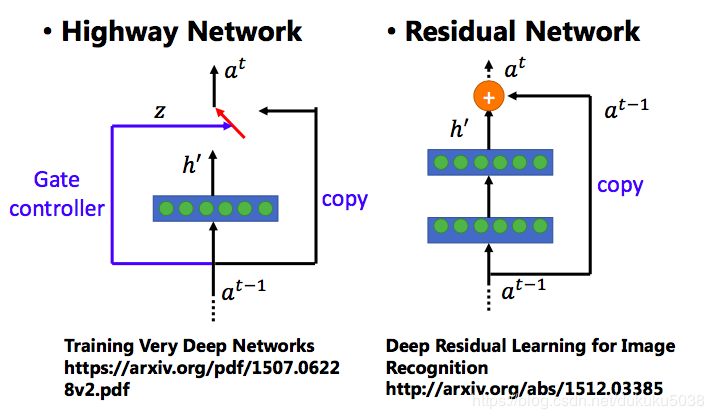

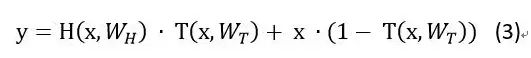

稍微扩充一下 Highway Network, 论文 , 公式如下,其中:

流程图

对比 ResNet